- オンライン

クロールバジェットとは?Googleの見解と影響する要因を解説

WEBサイトを運営していると、「クロールバジェットが足りなくなる」といった言葉を耳にすることがあるだろう。

クロールバジェットとは、ひと言でいうと『クロールの割り当て』のこと。

Googleのクローラーが、1回の訪問でどれくらいの情報量をGoogleのデータベースに格納することができるのかを表す際に使われる。

しかしながら、当のGoogleには、「クロールバジェット」として巷で使われている用語や考え方は存在しない。

この記事では、分かりづらい「クロールバジェット」について、Googleの見解を元に、その影響や注意点を探っていく。

この記事でわかること |

・クロールバジェットとは |

記事後半では、日々のWEB施策として重要なクロールの最適化についても触れていくので、クロールバジェットの影響が気になる人は試してみてほしい。

まずは、「クロールバジェットをどう捉えればいいのか?」というところから理解を深めていこう。

目次

1.クロールバジェットとは

クロールバジェットとは、1つのサイトに対してGoogleのクローラーが巡回できる上限枠(割り当て枠)のことを指す。

チェック! |

Googleの検索エンジンには、登録されているWebサイトを随時巡回するクローラー(Googlebot)が存在している。

検索エンジン内部を絶え間なく巡回するクローラーが集めてきた1サイトごとの情報を、検索エンジンが内部のアルゴリズム(検索キーワードに対する検索順位を決定するためのルール)と照らし合わせ、最終的にサイトの評価を行っていくシステムだ。

しかしながら、インターネットが普及した現在、日々数え切れないほど多くのWebサイト(ページ)が生まれており、それは、クローラーがWebページを巡回する能力の限界を超えるほどである。

こうしたことから、「クロールバジェット」=「クロールの割り当て枠」という考え方が生まれた。

実際、クローラーにはサイトで見られるページ数の上限が設定されており、可能性として、ページ数が上限を超えてしまうと一部の内容を認識することができなくなることもあり得る。

冒頭で例に挙げた『クロールバジェットが足りなくなる』、といった事態が起こり得るのだ。

ただ、クロールバジェットは基本的に大きめの数値に設定してあり、よほど大きなサイトで無い限りほとんど影響はないと見られている。

さらに着目すべきは、Googleでは「クロールバジェット」という用語や概念を採用していないことだ。

2.Googleの見解|「クロールの割り当て」が表すものを一言で説明できるような言葉はない

実は、いわゆる「クロールバジェット」という巷で使われている用語、及び考え方は、Googleには存在していない。

2017年1月17日にGoogleは公式ブログで「Googlebot のクロール バジェットとは?」という記事を公開した。

冒頭に書かれた文章を紹介しよう。

“昨今、「クロールの割り当て」についてさまざまな定義を耳にします。しかし、Googleの外部で「クロールの割り当て」が表すあらゆるものを一言で説明できるような言葉はありません。” |

このように、クロールバジェットの存在を否定するような発言がされているのだ。

さらに、発言は以下のように続く。

サイトに価値の低い URLが多数ある場合、そのサイトのクロールやインデックス登録に悪影響が及ぶ可能性があります。まず重要なのは、以下で述べるように、クロールの割り当てとは、ほとんどのパブリッシャーの方々にとって気にすべきものではない、ということです。新しいページが公開された当日にクロールされることが多い場合、ウェブマスターの方がクロールの割り当てを重視する必要はありません。同様に、サイトのURLが数千もない場合、そのサイトのクロールはたいてい効率的に行われます。” |

つまり、大規模なWebサイトを運営していない限り(サイトのURLが数千もない場合)、クロールバジェット(と一般にいわれる「クロールの割り当て」)を、意識する必要はないということだ。

3.クロールバジェットに影響を及ぼす要因・影響を受けるサイト

意識する必要はないといっても、あなたが大規模サイトの運営者なら、あるいは将来、中規模以上のサイト運営をめざすなら、クロールバジェットに影響を及ぼす要因について把握しておいた方がいいだろう。

ここでは、クロールバジェット(Googleのいう「クロールの割り当て」)に影響を及ぼす要素と、影響を受けるサイトについて解説していく。

SEOの知識のひとつとして、頭の片隅にとどめておいてほしい。

3-1.クロールバジェットに影響を及ぼす要素

Googleは、クロールバジェットの存在について先述のように否定的な発言をする一方で、「クロールの必要性」や「クロールの割り当てに影響する要因」を提示している。

(参照元:Google|Googlebot のクロールの割り当てについて)

3-1-1.クロールの必要性

クロールの必要性は、クロールバジェットに影響を及ぼす要素のひとつと考えられる。

検索エンジンに、インデックスされる必要性がないと判断された場合に、いわゆる「クロールの割り当て」が減ってしまう可能性があるのだ。

検索エンジンがクロールする必要があるかどうかを判断する上で、重要な指標となるのが以下の2つだ。

【人気度】 | インターネット上で人気の高い URL ほど、Google のインデックスで情報の新しさが保たれるよう頻繁にクロールされる傾向があります。 |

【古さ】 | Google のシステムでは、インデックス内の URL が古くなり無効とならないようにしています。 |

引用元:Google|クロールの割り当てについて「クロールの必要性」

クロールの必要性の対策は、「4-4.コンテンツの品質を改善する」で解説するので、合わせて参考にしてほしい。

3-2-2.クロールの割り当てに影響する要因

Googleでは「クロールの割り当てに影響する要因」として、価値の低いURLが多数あるとサイトのクロールやインデックス登録において、悪影響を及ぼす可能性があると述べている。

そこでは、「価値の低いURLの例」として次のようなものが挙げられている。

【価値の低いURL】

・ファセットナビゲーション(※1)とセッションID(※2) |

・サイト内の重複コンテンツ(※3) |

・ソフトエラーページ(※4) |

・ハッキングされたページ |

・無限のスペース(※5)とプロキシ |

・質の低いコンテンツやスパムコンテンツ |

(※1)ファセットナビゲーション:サイトのナビゲーションの種類を指す用語。多くの要素でサイト内検索ができる場合、あらかじめユーザーに使いやすいだろう検索条件をサイト側が用意しておくと、ユーザーはそれを選ぶだけでコンテンツを絞り込んでいける。

たとえばAmazonでは、書籍に関して「文学」「評論」といったカテゴリー、「単行本」「コミック」といったフォーマット、配送オプション、カスタマーレビューの平均、価格などの切り口で、ファセットナビゲーションを用意している。Googleセントラル検索|ファセットナビゲーション

(※2)セッションID:セッションに紐付けた識別用のID。Googleセントラル検索

(※3)サイト内の重複コンテンツ:ユーザーや追跡情報がURLパラメータを介して保存されている場合、同じページに多数のURLを介してアクセスできるため、コンテンツが重複する可能性がある。Googleセントラル検索

(※4)ソフトエラーページ:URL にアクセスしたときに、ページが存在しないことをユーザーに伝える404ページを表しながら、200レベル(成功)のコードを返すエラーページ。Googleセントラル検索|クロールエラーがソフト404を報告するようになりました

(※5)無限のスペース:Googlebotがウェブをクロールすると、「無限のスペース」と呼ばれるものが見つかることがある。これらは非常に多数のリンクであり、Googlebotがインデックスに登録するための新しいコンテンツをほとんど提供しない。これがサイトで発生した場合、これらのURLをクロールすると不要な帯域幅が使用され、Googlebotがサイトの実際のコンテンツをインデックスに登録できなくなる可能性がある。Googleセントラル検索|無限のスペース

これらが、Googleがクロールする価値が低いと考えているWebサイト(ページ)の定義ということだ。

実際、このようなURLがサーバーのリソースを浪費していると、価値の高いページへのクローラーの巡回を妨害してしまう。

3-2.クロールバジェットの影響を受けるサイト

クロールバジェットの影響を受ける可能性が危惧されるのは、Googleの見解にもある通り、サイトのURLが数千以上ある規模の大きなサイトだ。

ページ数が数千、数万とあり、コンテンツがめまぐるしく更新されるサイトでは、ページ数が膨大でコンテンツが重複しやすいことがクローラーの巡回を妨げる要因となる。

ここでいう大規模サイトとして、基本的には、下記のような大規模なECサイト(※1)やCGMサイト(※2)をイメージするといい。

(※1)ECサイト:自社の商品やサービスを、インターネット上に置いた独自運営のWEBサイトで販売するサイト(※2)CGMサイト:掲示板やクチコミサイトなど、一般ユーザーが参加してコンテンツができていくメディアのこと

大規模なECサイト | 「Amazon」、「楽天」、「Yahoo!ショッピング」、「メルカリ」など |

大規模なCGMサイト | 「アメーバブログ」、「おしえて!goo」、「価格.com」など |

毎日のように数百、数千というページが無尽蔵に生成されるサイトでは、「重複しているのでは?」「必要なページなのか?」と疑われるコンテンツが増えやすく、本来クロールされるべきページが埋もれてしまう可能性がある。

4.クロールを最適化する4つの方法

クロールの最適化とは、適切なページにクローラーが巡回できるようにすること。

クロールが不要なページにクローラーが行かないようにすること、とも言い換えられる。

ここではクロールを最適化する4つの方法について述べていく。

・価値の低いURLをなくす

・クロールさせる必要のないページは「robots.txt」でクロール拒否の設定をする

・定期的にサイトマップを更新する

・コンテンツの品質を改善する

サイトの健全な運営のために、しっかり把握しておこう。

4-1.価値の低いページをなくす

クロールする価値が低いページをなくすことで、クロールさせたいページへのクロール頻度が向上する可能性がある。

Googleの考える「価値が低いURL」は前章の「クロールの割り当てに影響する要因」で述べた通りだ(ハッキングされたページやスパムコンテンツなど)。

クローラーの健全な巡回を妨害しないよう、下記のような方策で、価値が低いと見なされるページを極力なくしていこう。

・プログラムによって自動生成されたページがないか確認して削除する |

・重複ページを削除する |

・無断複製されたコンテンツの有無を確認して削除する |

・特定のキーワードで上位表示されるためだけに作られた誘導ページを削除する |

4-2.クロールさせる必要のないページは「robots.txt」でクロール拒否の設定をする

クローラーは特に指示がなければ、全てのページをクロールしようとするため、サイトには残したいがクロールさせる必要のないページは、「robots.txt」(※)を使ってクロール拒否の設定を行っておこう。

(※)「robots.txt」:クローラーに特定のページをクロールさせないように設定できるファイルのこと

ここでいう必要のないページとは、Googleから価値が低いとみなされるが、サイトには残しておきたいページ(ファセットナビゲーション(※)など)のことだ。

(※)ファセットナビゲーションとは、「クロールの割り当てに影響する要因」でも紹介したように、サイト側が用意した検索条件をユーザーが選択することで、サイト内のコンテンツを絞り込めるナビゲーションの仕組み。それ自体は便利な機能だが、重複ページ(価値が低いページ)が大量に生成されることがある。

クロールの必要のないページを「robots.txt」で除外すれば、その分、価値のあるページをクロールしてもらいやすくなる。

ただし、外部ページから参照がある場合は、「robots.txt」で除外していてもインデックスされてしまうケースがあるので、下記のような方策も合わせて講じておくと良い。

・内部リンクの正規化 |

・noindex(※)を適切に使用 |

(※)noindex:メタタグのひとつ。 サイト内のページを検索結果に表示させたくない時に使う

「robots.txt」関連記事 |

4-3. 定期的にサイトマップを更新する

クロールの最適化するためには、定期的にサイトマップを更新することが重要だ。

サイトマップとは、自分のWebサイトがどのような構造なのか、どのようなコンテンツなのかについて検索エンジンに伝えるためのものだ。

Googleのクローラーは定期的にサイトマップの内容を確認しているため、サイトマップを更新することで新しく追加したページや更新したページの情報が伝わり、効率良くクロールしてもらえる可能性が高まる。

定期的な更新によって重要なページへのクロールを促進することができるのだ。

サイトマップ自動更新の設定をしている人は問題ないが、まだの場合は、クロール最適化のために設定しておこう。

4-4.コンテンツの品質を改善する

クロールの頻度を上げるための施策として、コンテンツの品質改善を行うことも忘れてはならない。

前章で述べたように、クローラーは人気の高さや、情報の新しさを基準にして、クロールの必要性を判断する。

低品質なコンテンツは人気がないページとみなされ、クロールの必要性が低いページと判断されてしまうのだ。

人気の高いページとは、言い換えれば、質の高いコンテンツを掲載しているページということだ。

クロールを最適化させたいURLが人気の高いページと判断されるように、質の高い充実した内容の魅力的なコンテンツ作成を心がけよう。

チェック! クロールの最適化として、5回以上のリダイレクトチェーンを避けることも覚えておいてほしい。 リダイレクトチェーンとは、URLからURLへ転送させるリダイレクトが複数回繰り返されている状態のこと。 リダイレクトチェーンが起こっていると、クロールに負荷がかかってしまうことが考えられる。 ある質問の場で、リダイレクトの問題について問われたGoogleのJohn Mueller(ジョン・ミューラー)氏は、「リダイレクトの繰り返しがランキングに悪影響を及ぼすことはない」としながらも、 「1つ覚えておくことがあるとしたら、5回までのリダイレクトを私たちはその場でたどるということだ。リダイレクトが5回を超えると、次のクロールのサイクルに回される。リダイレクトの繰り返しは、特にモバイルでは表示速度が非常に遅くなる。」 参照元:海外SEO情報ブログ|リダイレクトの繰り返しはSEOには悪影響なし、しかしユーザー体験にはマイナス と、話している。 5回以上のリダイレクトはクロールに負荷をかけ、ユーザーにとっても表示速度が遅くなるという悪影響を与えるということだ。 5回以上のリダイレクトを起こすことはあまりないとは思うが、不要なリダイレクトのページは早急に削除し、Webサイトの構造を簡潔化することを心がけよう。 |

5.Google Search Consoleでクロールの頻度を確認しよう

ここまで読んでクロールバジェットがわかってきた方の中には、自社サイトが一体どのくらいの頻度でクロールされているのか気になってきた人がいるに違いない。

今後の方針を見定めるためにも、「Google Search Console」を使って、今のクロール状況を確認してみよう。

チェック!

GoogleへのURL登録から、Google検索キーワードの表示回数や順位の推移、サイトが抱えている問題点の検出にも使えるので、サイトに携わる人は必ず登録しておこう。 |

ここでは、Google Search Consoleを使った下記の確認方法を解説する。

・クロールの頻度を確認する

・各ページの最新クロール日を確認する

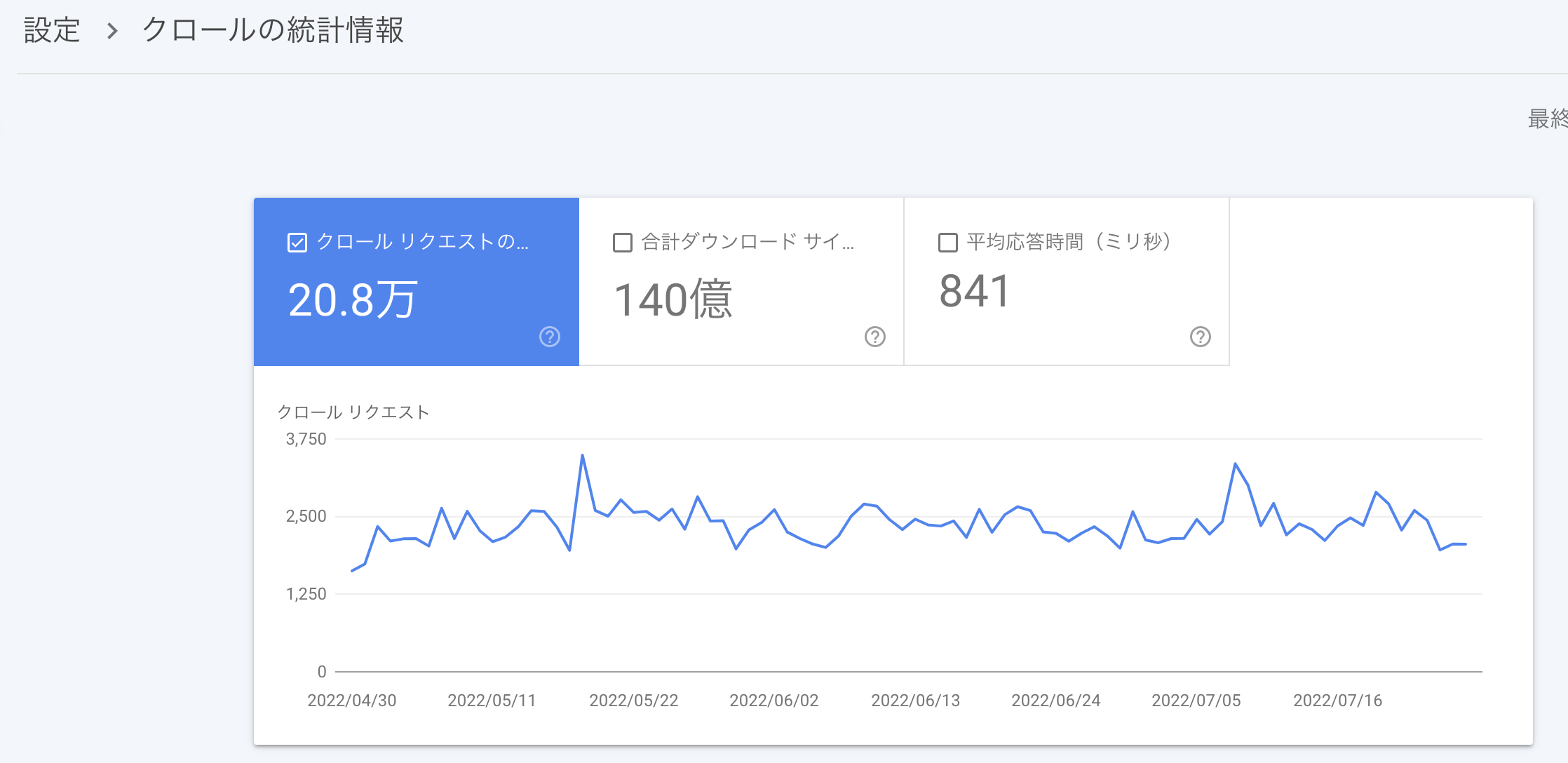

5-1.クロールの頻度を確認する

どのくらいクローラーが訪れているか、クロールの頻度の確認は下記手順で行う。

手順1|Google Search Consoleにログイン |

手順2|左メニューの「設定」をクリック |

手順3|「設定」画面にある「レポートを開く」をクリック |

クロールの統計情報(例)

|

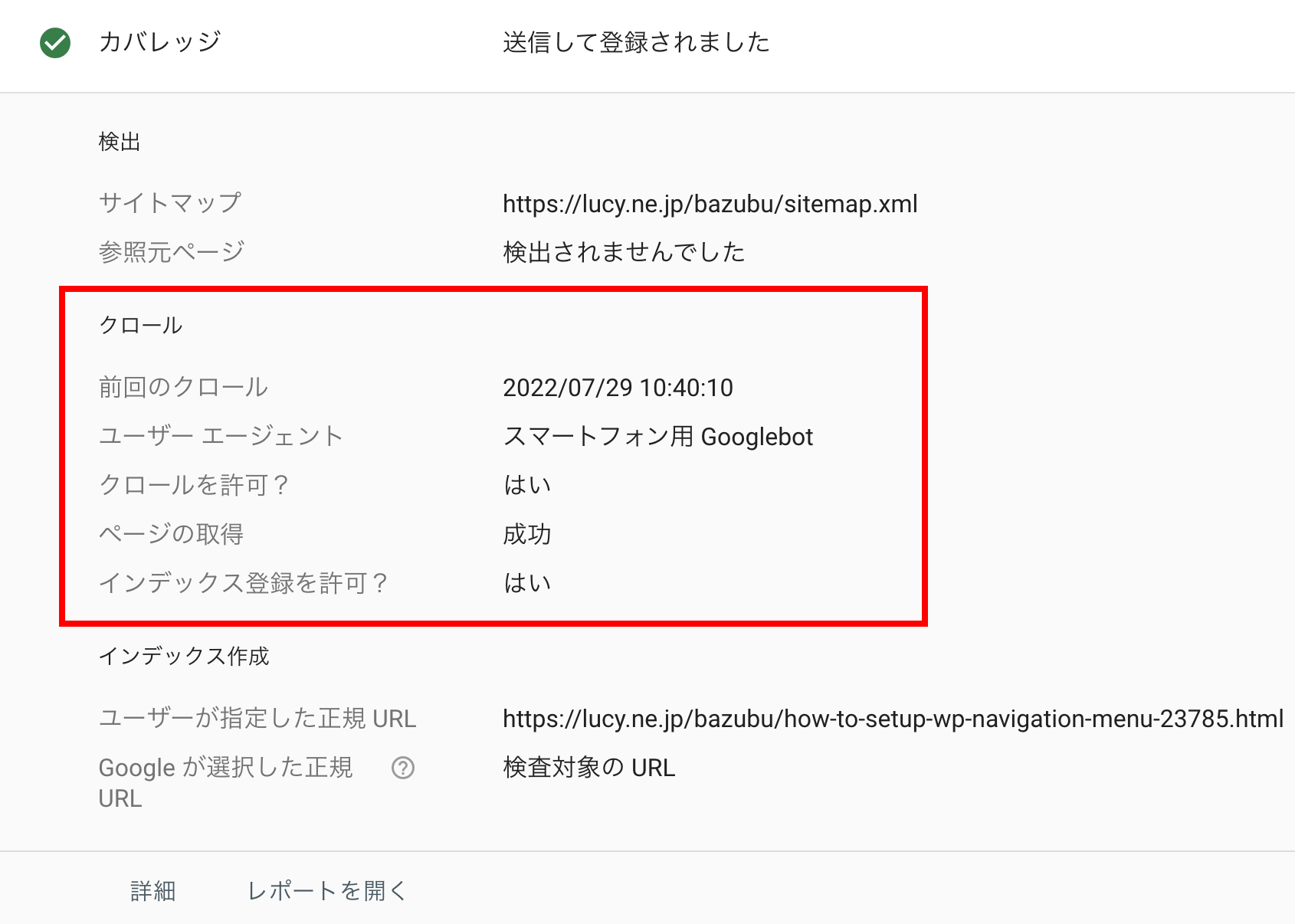

5-2.各ページの最新クロール日を確認する

各ページの最新クロール日(ページに最後に訪問した日)の確認は下記手順で行う。

手順1|Google Search Consoleにログイン |

手順2|「URL検査」をクリック |

手順3|最新クロール日を確認したいページのURLを入力 |

手順4|エンターキーを押すと「URL検査処理」がスタート |

手順5|完了画面が表示されたら、「カバレッジ」の右端にある下向きの矢印を左クリック |

カバレッジ詳細画面にある「前回のクロール」の日付が、WEBページにクローラーが来た最新クロール日ということだ。

前回のクロール日 = 最新クロール日(例)

|

6.クロールバジェットのよくある質問|Q&A

最後に「Googleウェブマスター向け公式ブログ」を元に、クロールバジェットに関するよくある質問と回答を紹介する。

①クロールはランキング要素になりますか? |

②nofollowはクロールバジェットの影響があるのか? |

③alternateのURLや埋め込みコンテンツもクロールバジェットに含まれますか? |

順に見ていこう。

6-1.クロールはランキング要素になりますか?

クロールの速度や頻度は、検索順位に影響しないため、クロールが増えることが、必ずしもランキング上昇につながるとは限らない。

ただ、クロールを最適化する対策の中にはSEO対策として有効なものもあるため、一概に全て無意味な対策とはいえない。

クローラーや検索エンジンに向けた対策はSEOの内部対策の中でも重要となるため、積極的に行った方が良いといえる。

検索結果を作りあげるためには当然クロールが必要だが、そのこととランキングは別のことだと認識しておこう。

6-2.nofollowはクロールバジェットに影響がありますか?

クロールバジェットにおけるnofollow(※)の影響は、ページの状況次第である。

たとえばページ内でURLをnofollow設定しても、サイト内の他のページ、あるいは他サイトからそのページへのリンクを貼る際にもnofollw設定されていなければ、クロールされる場合もある。

そのため、nofollow設定にもかかわらずクロールされた場合は、クロールバジェットにも影響すると認識しておいた方がいいだろう。

(※)「nofollow」について:nofollowは、ページランクの計算にリンクを使用しないように検索エンジンに指示するWebページのハイパーリンクの設定。nofollowを設定することで、リンク先ページのクロールを拒否することができる。外部リンクはSEOにおいて重要な要素となるため、無関係なWebサイトのリンクをnofollow設定することで、SEOの評価に影響を与えない効果がある。

6-3.alternateのURLや埋め込みコンテンツもクロールバジェットに含まれますか?

基本的に、すべてのURLはクロールバジェットに加えられる。

よって、AMPや、hreflangのalternate要素(※1)も、CSSやJavaScript のような埋め込みコンテンツ(※2)も、クロールバジェットに含まれる。

また、長いリダイレクト チェーン(※3)もクロールに悪く影響する。

(※1)alternate要素:alternate(オルトネイト)要素とは、スマホサイトや多言語版のページなど、現在のページの代替ページの存在をGoogleに伝えるためにHTMLファイルのheadタグ内に記述するhtmlタグのひとつ。これを指定することで、「検索エンジンが内容が同じなのにURLが違う=マイナス評価」ということを防ぐ意味がある。

(※2)埋め込みコンテンツ:HTML文書に動画や音声などの他のリソースを埋め込んだり、他の言語で書かれたコンテンツを挿入したりするもの。

(※3)リダイレクトチェーン:リダイレクトを何度も繰り返すこと。

7.まとめ

現状、大規模なWebサイトを運営していない限り、クロールバジェットを、ことさら意識する必要はないといえる。

ただ、その意味や存在を理解しておくことは重要だ。

何らかの原因でクローラーに負荷を与えるようなことがあれば、いつなんどき、自社サイトの健全な運営が妨げられないとも限らない。

記事を参考に、クロールの最適化や、SearchConsoleでの確認を定期的に行ってほしい。

無料eBook:バズ部式マーケティング

広告費を1/10にして売上を倍増させる全手法

広告に頼り切ったマーケティングの打開策としてコンテンツマーケティングについて調べているけれど、よく分からないと悩んでいませんか?

本書は弊社やクライアント様がコンテンツマーケティングに取り組み

- ・SEOのみで月間100万PV集めた方法

- ・平均6.92%のコンバージョン率が出た新規顧客獲得法

- ・CPLやCPAを大幅に改善した方法とそのからくり

など、コンテンツマーケティングの効果と、具体的な施策内容を全94ページに渡って詳細に解説しているものです。

ぜひ、貴社のWEBマーケティングにもご活用ください。